De la robotique aux automobiles, en passant par l’électroménager, l’intelligence artificielle est aujourd’hui implantée dans la plupart des systèmes numériques. Afin d’en faire un assistant quotidien efficace et de faciliter son intégration dans nos sociétés, les scientifiques tentent de perfectionner l’IA dans le but de mimer le plus fidèlement possible, tout en les optimisant, les facultés d’apprentissage et d’intégration humaines. Dans ce cadre, un nouvel algorithme permet aujourd’hui à l’IA d’apprendre de ses erreurs.

Fondée en 2015 par Elon Musk et Sam Altman, OpenAI, l’association de recherche en intelligence artificielle basée à San Francisco, s’est donnée comme objectif de développer et promouvoir une IA la plus humanisée possible. Depuis sa création, l’organisation a effectué plusieurs avancées en ce sens. Il y a quelques mois, les chercheurs présentaient une IA capable de constituer elle-même sa propre base de connaissances en cherchant et intégrant de manière autonome toutes les informations à sa portée sur Internet (journaux, manuels universitaires, études scientifiques, etc).

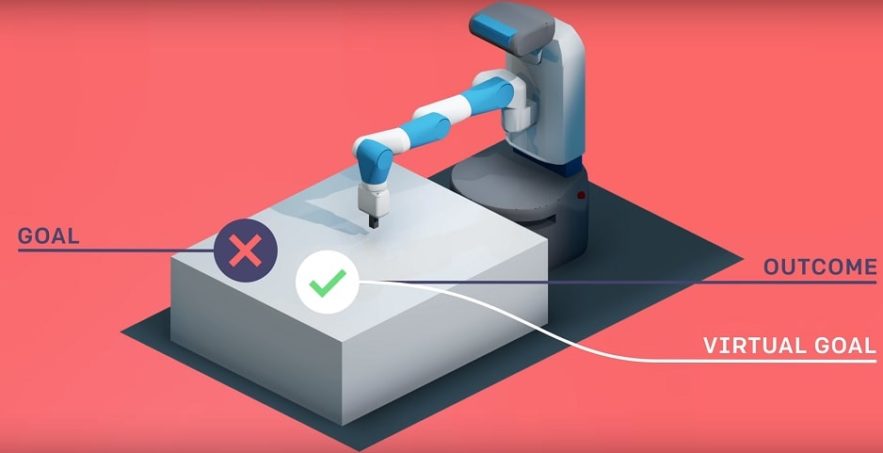

Continuant sur une lancée d’optimisation de l’auto-apprentissage de ses machines, OpenAI vient de présenter un tout nouvel algorithme permettant à ces dernières d’apprendre de leurs erreurs et d’agir ainsi en conséquence. Cet algorithme open-source baptisé « Hindsight Experience Replay » (HER) aide les agents artificiels à analyser rétrospectivement leurs échecs et à considérer ceux-ci non comme des erreurs, mais comme des succès non-intentionnels.

« L’idée fondamentale derrière HER est que cet algorithme mime ce que les humains font intuitivement : même si nous n’avons pas réussi à atteindre un but spécifique, nous avons au moins réussi à en atteindre un autre » expliquent les chercheurs. « Alors pourquoi ne pas prétendre que nous voulions atteindre initialement ce but là plutôt que celui au regard duquel nous avons échoué ? ».

En d’autres termes, à chaque fois que l’IA échoue à remplir un objectif, cela compte quand même comme un autre objectif atteint. En effet, considérer ses erreurs comme un objectif à part entière est une étape primordiale dans l’apprentissage. Lorsque l’on fait du vélo, les premiers essais sont généralement des échecs. Cependant, ces essais nous apprennent ce que l’on doit et ne doit pas faire pour avancer et conserver son équilibre. Chaque échec est une étape importante vers l’objectif final. Et c’est typiquement de cette manière que fonctionne le cerveau humain.

Pour optimiser ce concept, HER récompense les réussites comme les échecs. Les modèles d’apprentissage renforcé actuels comportent tous un système de récompense divisé en deux catégories : soit l’IA n’est récompensée que quand elle remplit son objectif, soit elle est récompensée en fonction de son avancée vers l’objectif défini. Ces deux méthodes ont leurs inconvénients. La première retarde l’apprentissage tandis que la seconde est difficile à implanter correctement selon l’IEEE Spectrum.

Cette vidéo montre la façon dont HER et son système de récompense optimisent la rapidité d’apprentissage :

En traitant avec du recul chaque tentative, réussie ou non, comme un but atteint, HER permet à l’IA d’apprendre plus vite et plus efficacement. « En adoptant cette méthode, l’algorithme d’apprentissage renforcé obtient une récompense dès lors qu’il remplit un objectif, même si ce n’était pas son objectif premier. En répétant ce processus, l’IA finira par apprendre comment atteindre des buts arbitraires, incluant les buts initialement fixés » précise OpenAI.

Même si ce nouvel algorithme représente une avancée notable dans l’auto-apprentissage des machines intelligentes, il ne rend pas pour autant cette assimilation facile. Matthias Plappert (OpenAI) explique en effet que « l’apprentissage avec HER sur de véritables robots reste compliqué car cela nécessite une très grande quantité de données ».